BP神经网络隐层数的选取

背景介绍

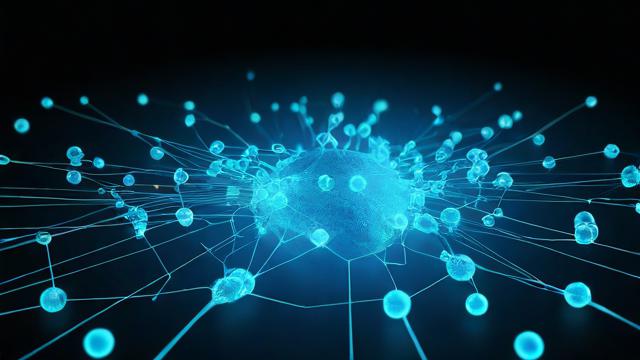

BP(Back Propagation)神经网络是一种多层前馈神经网络,通过梯度下降法进行误差反向传播,以最小化输出误差,其结构通常包括输入层、若干隐含层和输出层,隐含层的数量对网络的性能有着重要影响。

隐层数的重要性

隐含层是BP神经网络的核心部分,负责提取特征和传递信息,增加隐含层数可以增强网络的映射能力,提高分类精度和泛化性能,过多的隐含层数会增加网络复杂度,导致过拟合问题,选取合适的隐含层数对于BP神经网络的性能至关重要。

选取方法

试错法:根据经验逐个尝试不同数量的隐含层,通过交叉验证选择性能最好的网络结构,这种方法费时费力且不具备普适性,有时还会导致过拟合现象的发生。

平滑指数法:根据网络输出的平滑指数来判断隐含层数,平滑指数越大表示输出结果越平滑,网络性能越好。

复杂度法:根据网络复杂度来选取隐含层数,网络复杂度可以用参数个数、连接数等来衡量。

三分法:将隐含层节点数的选择过程划分为若干个连续的区间,然后通过一定规则逐步缩小搜索区间以逼近最优节点数,这种方法比传统试错法更具有系统性和科学性,可以在较短的时间内找到较优或最优的隐含层节点数。

经验法则:隐含层数应该等于输入层节点数目加上输出层节点数目的两倍,或者隐含层数应该在1到2个之间,这些经验法则可以作为初步参考,但具体还需结合实际问题和数据集进行调整。

实际应用中的考虑因素

在实际应用中,除了上述方法外,还需要考虑以下因素:

问题的复杂程度:对于简单问题,较少的隐含层即可满足需求;对于复杂问题,则需要更多的隐含层来提取特征。

数据的规模和质量:大规模、高质量的数据可以支持更复杂的网络结构;而小规模、低质量的数据则可能导致过拟合。

正则化技术:使用Dropout、L1/L2正则化等技术可以避免过拟合,提高模型的泛化能力。

混合方法:先用浅层神经网络对数据进行初步处理,再使用深层神经网络对处理后的数据进行精细建模,这种混合方法可以充分发挥浅层神经网络和深层神经网络的优势,提高模型的性能。

BP神经网络的隐含层选取是一个复杂而重要的问题,需要综合考虑多种因素,在实际应用中,可以根据具体问题和数据集的特点选择合适的方法来确定隐含层数,并通过实验和调整来优化网络结构以达到最佳的性能表现,随着深度学习技术的不断发展,BP神经网络将在更多领域发挥重要作用。

常见问题解答(FAQs)

如何选择最佳的隐含层层数?

选择最佳的隐含层层数可以通过试错法、平滑指数法、复杂度法、三分法以及经验法则等方法来确定,在实际应用中,建议结合具体问题和数据集的特点进行综合考虑,并通过实验和调整来优化网络结构以达到最佳的性能表现。

增加隐含层数一定能提高模型性能吗?

不一定,虽然增加隐含层数可以增强网络的映射能力和表达能力,但同时也会增加网络复杂度和训练难度,可能导致过拟合问题,在选择隐含层数时需要权衡模型的复杂度和泛化能力。

小伙伴们,上文介绍了“bp神经网络隐层数的选取”的内容,你了解清楚吗?希望对你有所帮助,任何问题可以给我留言,让我们下期再见吧。